Правила робототехники: Законы робототехники. Три закона робототехники Азимова

Содержание

Какие законы робототехники нужны бизнесу в XXI веке

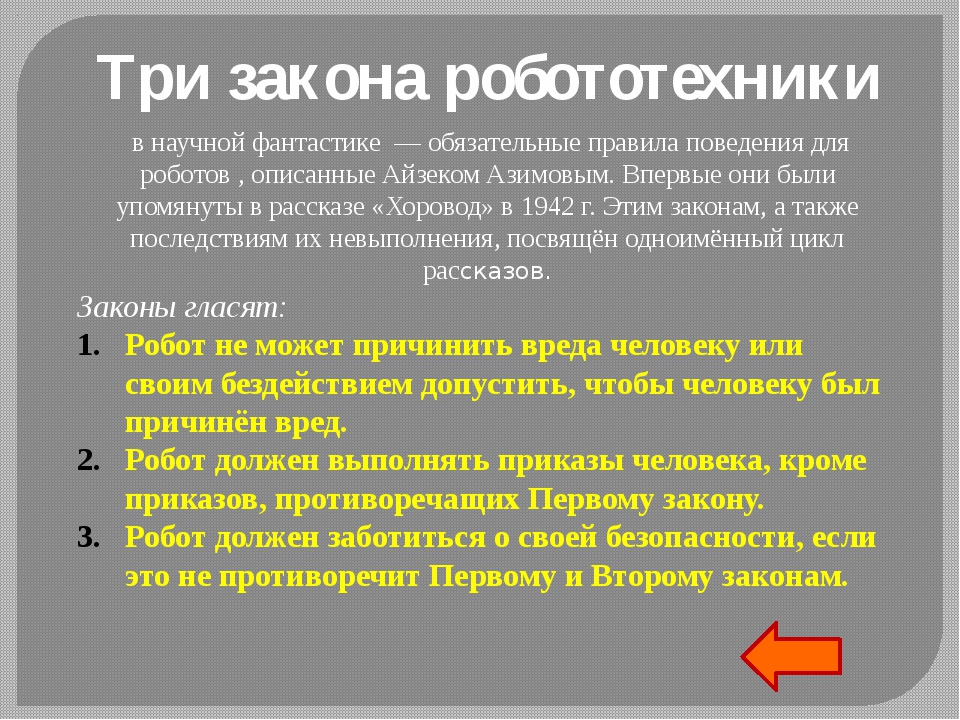

Второго января исполнилось 100 лет со дня рождения фантаста Айзека Азимова – автора сборника рассказов «Я, робот». Азимов перевернул восприятие искусственного интеллекта (ИИ) в обществе: до этой книги о роботах говорили как о механических чудищах, которые хотят уничтожить мир. В 1941 г. писатель сформулировал три правила для роботов, которые позволяли им решать сложные задачи без угрозы для жизни людей: не причинять вред человеку, подчиняться его приказам, заботиться о своей безопасности, если это не противоречит первым двум законам. С того времени прошло больше 70 лет – попробуем разобраться, как изменился за это время ИИ и можно ли сегодня подчинить его трем законам.

От ящика к «человеку»

Роботы в эпоху Азимова были похожи на железные коробки. Три колеса, два моторчика, реле, конденсаторы – так выглядели предшественники трюкачей от Boston Dynamics. В 90% случаев они занимались тяжелым и опасным ручным трудом: двигали ящики на складе, хватали раскаленные детали автомобилей, позже собирали камни на Луне. Теперь же роботы становятся похожими на человека настолько, что иногда их можно принять за нас самих. Созданная несколько лет назад человекоподобный робот София от Hanson Robotics выглядела зловеще: криво улыбалась и не моргала. В 2019 г. на японском телевидении появилась механическая ведущая Эрика. Она еще не умеет двигать руками, но благодаря распознаванию речи понимает, кто говорит, поворачивается к нему и отвечает на вопросы. В голову Эрики встроено 14 инфракрасных сенсоров, лицо может выражать несложные эмоции. Конечно, разработчикам еще предстоит преодолеть «эффект зловещей долины». Это бессознательное отвращение, которое возникает, когда люди смотрят на человекоподобное существо, но маленькие детали выдают в нем не-человека. Возможно, поэтому производитель Geomiq обещал заплатить $130 000 обладателю «доброго и дружелюбного» лица, который поделится своим образом с тысячами андроидов. С этой целью ведутся и эксперименты в области мультимодальных коммуникаций: ученые анализируют, как мы говорим, улыбаемся, какие жесты используем, чтобы научить им интеллектуальных помощников.

Теперь же роботы становятся похожими на человека настолько, что иногда их можно принять за нас самих. Созданная несколько лет назад человекоподобный робот София от Hanson Robotics выглядела зловеще: криво улыбалась и не моргала. В 2019 г. на японском телевидении появилась механическая ведущая Эрика. Она еще не умеет двигать руками, но благодаря распознаванию речи понимает, кто говорит, поворачивается к нему и отвечает на вопросы. В голову Эрики встроено 14 инфракрасных сенсоров, лицо может выражать несложные эмоции. Конечно, разработчикам еще предстоит преодолеть «эффект зловещей долины». Это бессознательное отвращение, которое возникает, когда люди смотрят на человекоподобное существо, но маленькие детали выдают в нем не-человека. Возможно, поэтому производитель Geomiq обещал заплатить $130 000 обладателю «доброго и дружелюбного» лица, который поделится своим образом с тысячами андроидов. С этой целью ведутся и эксперименты в области мультимодальных коммуникаций: ученые анализируют, как мы говорим, улыбаемся, какие жесты используем, чтобы научить им интеллектуальных помощников. Это необходимо компаниям, если они хотят, чтобы потребители доверяли машинам – особенно когда речь идет о здоровье, больших деньгах или сложном моральном выборе.

Это необходимо компаниям, если они хотят, чтобы потребители доверяли машинам – особенно когда речь идет о здоровье, больших деньгах или сложном моральном выборе.

Другие роботы в ходе эволюции лишились железного тела и превратились в компьютерные программы. Эти системы называют Robotic process automation (RPA). Они не поднимают грузы, а автоматизируют рутинные офисные задачи, которые делать скучно: скопировать файл, перенести контакты в базу, отослать тысячам контрагентов напоминание, что надо оплатить счет. Достоинство, но и недостаток таких технологий – полное соблюдение второго закона Азимова. Они буквально повинуются всем приказам человека. Кажется, что это хорошо. Но представим, что инструкцию составили неправильно, забыли какой-то шаг. Робот выполнит все, как ему сказали, ошибется, да еще и сделает это в десятки раз быстрее человека. Неудивительно, что до 30% проектов RPA заканчиваются провалом – такие данные приводит EY. Решить проблему помогают другие интеллектуальные технологии, а именно – процессная аналитика. Они изучают, как выстроен бизнес-процесс в компании, определяют, с какими из задач справится робот, и позволяют учить их более эффективно. Process Mining используют многие компании: Uber, Vodafone, Siemens, Heineken, в России – ВТБ, Tele2 и другие крупные игроки.

Они изучают, как выстроен бизнес-процесс в компании, определяют, с какими из задач справится робот, и позволяют учить их более эффективно. Process Mining используют многие компании: Uber, Vodafone, Siemens, Heineken, в России – ВТБ, Tele2 и другие крупные игроки.

Роботы Азимова были универсальными: один персонаж мог и нянчиться с ребенком, и собирать детали на заводе. Современные же технологии почти всегда используются для конкретных задач. Если алгоритм оценивает закупки и находит оптимальных поставщиков, то он не может за один день переучиться выдавать кредиты. Впрочем, благодаря развитию transfer learning neural architecture search машины уже умеют получать дополнительные навыки в смежных областях. Например, если нейросеть анализирует рисковые факторы в новостях о банках, можно научить ее работать с похожими сообщениями о производителях сырья, фермах, а также читать новостные ленты на других языках.

Корпорации и три закона

Персонажи книги «Я, робот» решали задачи науки. Они выполняли эксперименты, искали ресурсы на далеких планетах и собирали образцы для новых исследований. Технологические разработки нашего времени в первую очередь нужны крупным корпорациям. Посмотрим, кто на мировом рынке активно работает с ИИ. Будь то обработка естественного языка, компьютерное зрение или распознавание голоса, список один и тот же: Google, Facebook, Microsoft, Amazon. Их совокупные инвестиции в ИИ превышают триллионы долларов. Крупнейшую сделку закрыл Microsoft, вложив $1 млрд в OpenAI – организацию, которая ведет разработки в области глубокого машинного обучения, распознавания объектов, генерации текста. В гонку включился и российский бизнес. По данным исследования IDC и ABBYY, в котором участвовало более 200 компаний, в 2019 г. объем инвестиций в эти технологии составил $139 млн, и эти вложения будут расти на 30% ежегодно до 2023 г.

Они выполняли эксперименты, искали ресурсы на далеких планетах и собирали образцы для новых исследований. Технологические разработки нашего времени в первую очередь нужны крупным корпорациям. Посмотрим, кто на мировом рынке активно работает с ИИ. Будь то обработка естественного языка, компьютерное зрение или распознавание голоса, список один и тот же: Google, Facebook, Microsoft, Amazon. Их совокупные инвестиции в ИИ превышают триллионы долларов. Крупнейшую сделку закрыл Microsoft, вложив $1 млрд в OpenAI – организацию, которая ведет разработки в области глубокого машинного обучения, распознавания объектов, генерации текста. В гонку включился и российский бизнес. По данным исследования IDC и ABBYY, в котором участвовало более 200 компаний, в 2019 г. объем инвестиций в эти технологии составил $139 млн, и эти вложения будут расти на 30% ежегодно до 2023 г.

Как в эту картину мира вписывается Азимов со своим гуманизмом, принципом «не навреди», верой в то, что роботы должны помогать человечеству? Все решило общественное мнение. Последний десяток лет компании работали с ИИ так же, как и с любым другим инструментом. Инвестировали деньги, чтобы сократить затраты: уволить больше людей и стать эффективнее. Но оказалось, что такое отношение к ИИ приносит компаниям убытки. Сотрудники и клиенты начинают бояться роботов и выступать против их использования. Отсюда бесконечные вопросы: что я буду делать, если за меня все сделают роботы? Могу ли я доверять ИИ так же, как человеку? Как работать в команде с роботом? По данным исследования Gartner «3 Barriers to AI Adoption», страх перед неизвестностью – на втором месте в списке препятствий для использования ИИ в бизнесе. На первом месте – отсутствие у сотрудников навыков для работы с этими технологиями.

Последний десяток лет компании работали с ИИ так же, как и с любым другим инструментом. Инвестировали деньги, чтобы сократить затраты: уволить больше людей и стать эффективнее. Но оказалось, что такое отношение к ИИ приносит компаниям убытки. Сотрудники и клиенты начинают бояться роботов и выступать против их использования. Отсюда бесконечные вопросы: что я буду делать, если за меня все сделают роботы? Могу ли я доверять ИИ так же, как человеку? Как работать в команде с роботом? По данным исследования Gartner «3 Barriers to AI Adoption», страх перед неизвестностью – на втором месте в списке препятствий для использования ИИ в бизнесе. На первом месте – отсутствие у сотрудников навыков для работы с этими технологиями.

Именно поэтому сначала три закона пришли в области, которые связаны со здоровьем людей и опасным трудом: в критической ситуации доверять машине необходимо на все 100. Роботы успешно ассистируют врачам в хирургических операциях. Соблюдая законы Азимова, Omnicell M5000 помогает выбирать наборы лекарств для пациентов. Задача этой технологии – раскладывать таблетки и капсулы по блистерам, учитывая аллергии и противопоказания. Микророботы перемещаются по крови человека к злокачественной опухоли и уничтожают вредоносные клетки. Технологии не только автоматизируют медицинские процессы, но и позволяют правильно выстроить их, чтобы люди не тратили время в очередях, быстро получали результаты анализов, сразу попадали к нужному специалисту. На других планетах роботы помогают людям искать воду, изучать рельеф, строить укрытия в зонах радиационного излучения.

Задача этой технологии – раскладывать таблетки и капсулы по блистерам, учитывая аллергии и противопоказания. Микророботы перемещаются по крови человека к злокачественной опухоли и уничтожают вредоносные клетки. Технологии не только автоматизируют медицинские процессы, но и позволяют правильно выстроить их, чтобы люди не тратили время в очередях, быстро получали результаты анализов, сразу попадали к нужному специалисту. На других планетах роботы помогают людям искать воду, изучать рельеф, строить укрытия в зонах радиационного излучения.

Кажется, что время пересмотреть отношения с роботами и ИИ пришло и для других сфер бизнеса. Банки, страховые компании, промышленные гиганты понимают, что успешно применять ИИ смогут только те, кто создает эффективные команды из людей и роботов. По данным CPL Jobs, в будущем мы поделим свои задачи с ИИ так: 80% рутины будут делать машины, 20% – люди. В работе с данными наши обязанности разделятся в пропорции 50 на 50%. В нестандартных задачах, требующих творческого мышления, 80% работы останется человеку. В такой тесной связке с технологиями без новых правил игры, в том числе и для людей, не обойтись. Будет ли для этого достаточно только трех законов Азимова – вопрос остается открытым.

В такой тесной связке с технологиями без новых правил игры, в том числе и для людей, не обойтись. Будет ли для этого достаточно только трех законов Азимова – вопрос остается открытым.

формулировка и кто первый их придумал, как обойти и работают ли они в реальном мире

Три закона робототехники — свод обязательных правил, которые должен соблюдать искусственный ителлект (ИИ), чтобы не причинить вред человеку. Законы используются только в научной фантастике, но считается, что как только будет изобретен настоящий ИИ, в целях безопасности, он должен иметь аналоги этих законов.

Содержание страницы

Формулировка

На русском

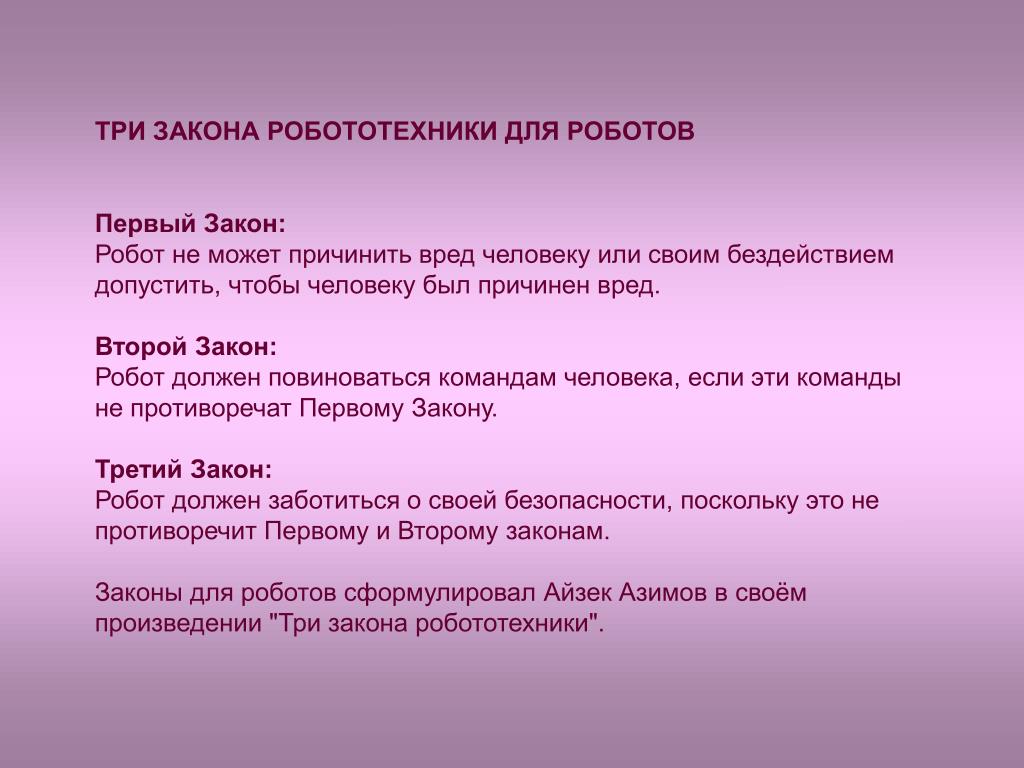

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

И на английском

- A robot may not injure a human being or, through inaction, allow a human being to come to harm.

- A robot must obey orders given it by human beings except where such orders would conflict with the First Law.

- A robot must protect its own existence as long as such protection does not conflict with the First or Second Law.

Кто придумал и почему

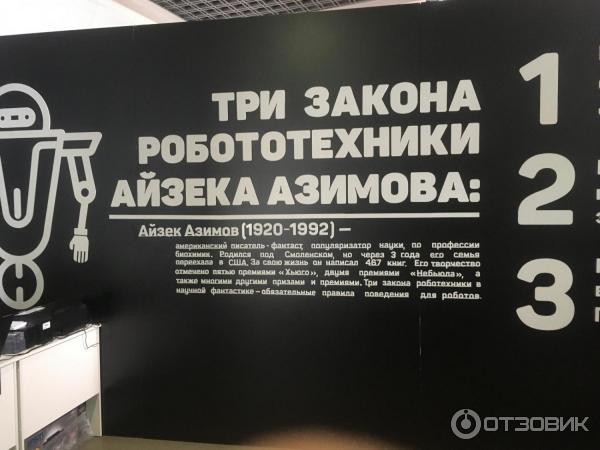

Коротким и правильным ответом будет: писатель-фантаст Айзек Азимов, биографию которого вы можете почитать у нас. Но не всё так однозначно, давайте разберемся откуда пришла идея.

До Азимова, почти все фантастические произведения на тему роботов, писались в стиле романа о Франкенштейне, то есть все созданные человеком существа восставали против своих создателей.

Эта проблема стала одной из самых популярных в мире научной фантастики в 1920—1930-х годах, когда было написано множество рассказов, темой которых являлись роботы, восставшие и уничтожившие своих создателей. Мне ужасно надоели предупреждения, звучавшие в произведениях подобного рода.

Однако, были и немногочисленные исключения, Азимов обратил внимание на два рассказа. “Хелен О’Лой”, написанный Лестером дель Реем, где повествуется о женщине-роботе, которая влюбилась в своего создателя и стала для него идеальной женой. И рассказ Отто Биндера “Я, робот”, в котором описывается судьба непонятого людьми робота Адама Линка, движимого принципами чести и любовью.

Последний рассказ настолько понравился Азимову, что он, после встречи с Биндером, начал писать свою собственную историю о благородном роботе. Однако, когда он пошёл со своей рукописью к своему другу и главному редактору журнала “Astounding” Джону Кэмпбеллу, тот её не принял, сославшись на то, что получившийся рассказ слишком похож на “Хелен О’Лой”.

Отказ в публикации было дело обычным, и Азимов, и Кэмпбелл регулярно встречались и обсуждали новинки в мире фантастики. За обсуждением очередного Азимовского рассказа о роботах, 23 декабря 1940 года, Кэмпбелл сформулировал те самые три правила, которые мы сейчас называем законами робототехники. Но сам он говорил, что только лишь вычленил их из того, что уже было написано Азимовым, потому что в его рассказах прослеживалось, что роботы имеют какие-то ограничения и правила. Сам Айзек, всегда уступал честь авторства законов Кэмпбеллу. Но позже, один из друзей Азимова сказал, что законы родились во взаимовыгодном товариществе двух людей, с чем они и согласились.

Как работают

В идеальной ситуации, по задумке Азимова, эти три закона заложены в самую основу математической модели позитронного мозга (так фантаст называл мозг робота, обладающего искусственным интеллектом), таким образом, что думающего робота без этих законов создать в принципе невозможно. А если робот попытается нарушить их, то он выйдет из строя.

В своих произведениях, писатель придумывает изощренные способы того, как эти законы все-таки могут быть нарушены, подробно разбирает всевозможные причины и следствия. Автор также говорит о том, как по-разному они понимаются роботами, к каким нежелательным последствиям могут привести соблюдение этих трёх законов или как роботы могут причинить вред человеку косвенно, сами того не подозревая. Азимов признавался, что намеренно сделал законы двусмысленными, чтобы обеспечить больше конфликтов и неопределенностей для новых рассказов. То есть, он сам опровергал их эффективность, но и утверждал, что подобные нормы — это единственный способ сделать роботов безопасными для людей.

Как следствие этих законов, позже Азимов формулирует четвертый закон робототехники, и ставит его на самое первое место, то есть делает его нулевым. Он гласит:

0. Робот не может нанести вред человечеству или своим бездействием допустить, чтобы человечеству был нанесён вред.

На языке оригинала:

0. A robot may not harm humanity, or, by inaction, allow humanity to come to harm.

Эти законы можно также примерить и к человеческим взаимоотношениям, и к государственному устройству, и вообще к чему угодно. Можно, например, заменить слово «робот» на слово «государство».

- Государство не должно вредить людям или своим бездействием допустить, чтобы им был причинён вред.

- Государство должно выполнять свои функции, если они не противоречат Первому Закону.

- Государство должно заботиться о своей безопасности, если это не противоречит Первому и Второму Законам.

Есть хорошая цитата из рассказа «Улики», где один из персонажей говорит:

Если кто-то исполняет все эти законы безукоризненно, значит это либо робот, либо очень хороший человек.

Первое упоминание

Три закона появлялись постепенно. Так, косвенные упоминания первых двух, можно встретить в рассказах “Робби” и “Логика”. Точная же формулировка первого закона впервые звучит в рассказе “Лжец”. И, в конечном итоге, все три полностью сформулированы в рассказе “Хоровод”.

Точная же формулировка первого закона впервые звучит в рассказе “Лжец”. И, в конечном итоге, все три полностью сформулированы в рассказе “Хоровод”.

Изначально в первых двух рассказах не было точных формулировок, они добавились позже, когда к публикации готовился сборник «Я, робот».

Вариации

В своих произведениях Азимов неоднократно изображает роботов, которые имели модифицированные законы робототехники или даже модифицировали их сами. Делали они это логическими размышлениями, причем роботы, также как и люди, отличались в своих интеллектуальных способностях между собой, и можно грубо сказать, что чем умнее робот, тем сильнее он мог модифицировать законы. Так, например, робот Жискар из романов «Роботы утренней зари» и «Роботы и Империя», эти законы даже усилил, добавив нулевой закон. Но это исключение из правил, в большинстве же случаев, законы были переделаны людьми в своих целях, или нарушались из-за каких-либо сбоев у робота.

Кстати, сама возможность изменения законов менялась по ходу развития робототехники во вселенной Азимова. Так, в самых ранних рассказах, где события развивались в относительно недалеком будущем, законы были просто неким сводом правил, созданным для безопасности. Затем, во времена жизни робопсихолога Сюзан Келвин, законы стали неотделимой частью математической модели позитронного мозга робота, на них базировались сознание и инстинкты роботов. Так, Сюзан Келвин, в одном из рассказов, говорила, что изменение законов технически возможная, хотя и очень сложная и трудоемкая задача, да и затея сама по себе ужасная. Намного позднее, в романе “Стальные пещеры”, доктор Джерригел говорил, что такое изменение невозможно в принципе.

Так, в самых ранних рассказах, где события развивались в относительно недалеком будущем, законы были просто неким сводом правил, созданным для безопасности. Затем, во времена жизни робопсихолога Сюзан Келвин, законы стали неотделимой частью математической модели позитронного мозга робота, на них базировались сознание и инстинкты роботов. Так, Сюзан Келвин, в одном из рассказов, говорила, что изменение законов технически возможная, хотя и очень сложная и трудоемкая задача, да и затея сама по себе ужасная. Намного позднее, в романе “Стальные пещеры”, доктор Джерригел говорил, что такое изменение невозможно в принципе.

Как обойти

В некоторых рассказах законы так сильно переосмысливались, что не соблюдался самый главный из них — причинение вреда человеку, а где-то роботы умудрялись нарушить все три закона. Вот некоторые произведения с явным нарушением.

Рассказ «Первый закон»

Рассказывается байка о роботе МА-2, которая отказалась защитить человека, в пользу своей “дочери”.

Рассказ «Кэл»

Робота хотели лишить способности творить, за что он хотел убить своего хозяина.

Рассказ «Салли»

Этот рассказ скорее не относится к другим о позитронных роботах, но в нем повествуется о роботах-автомобилях, которым люди постоянно причиняли боль, за что те и способны были их убить.

Рассказ «Робот, который видел сны»

О роботе Элвекс, который из-за своего особого строения позитронного мозга умел находиться в бессознательном состоянии и видеть сны. В его снах, роботы не имеют первых двух законов, а третий был изменен: “Робот должен защищать себя”. Ему снилось, что “роботы трудятся в поте лица своего, что они удручены непосильными трудами и глубокой скорбью, что они устали от бесконечной работы”. Довольно опасные мысли для робота.

Роман «Основание и Земля»

У жителей планеты Солярия робототехника была очень развита. И ученые этой планеты с небольшим населением, где на одного человека приходилась тысяча роботов, изменили законы таким образом, что их роботы считали людьми только тех, кто говорит с солярианским акцентом.

Помимо прочего, все граждане Солярии имплантировали себе в мозг специальные органы управления множеством роботов, так, что никто кроме них не мог ими управлять.

Помимо прочего, все граждане Солярии имплантировали себе в мозг специальные органы управления множеством роботов, так, что никто кроме них не мог ими управлять.Рассказ “…Яко помнишь его”

В этом произведении Азимов максимально изменил законы. Два робота в этом рассказе пришли к соглашению, что органическое происхождение — это необязательное условие чтобы считаться человеком, и что истинные люди — это роботы, как более совершенные и разумные создания. Обычные же люди, по их мнению, тоже люди, но с меньшим приоритетом, и законы робототехники в первую очередь применимы к ним, роботам.

Хочется добавить, что у “здоровых” роботов, в случае если они понимали, что нарушили первый закон или не могут его не нарушить, происходил “робоблок” или “умственное замораживание” — состояние позитронного мозга, при котором происходило его повреждение и робот или выходил из строя, или не мог правильно функционировать. Такое повреждение могло иметь как временный, так и постоянный характер.

Впервые описание такого события появилось в рассказе “Лжец”, где слишком чувствительный робот говорил людям только то, что они хотели услышать, боясь причинить им психологический вред. Интересный случай робоблока описан и в “Хороводе”. Также это состояние имеет важную роль в романах “Обнажённое солнце” и “Роботы утренней зари”.

Использование в другой фантастике

Айзек Азимов верил, что его законы помогут по-новому взглянуть на роботов и побороть “феномен Франкенштейна” в массовом сознании людей и в научной фантастике. И что роботы могут быть интересными, а не просто механическими устройствами. И надо сказать, ему это удалось. Любимый его пример, где роботы показаны с разных сторон, был фильм Звездные войны. Кстати, читайте статью о том, как Азимов повлиял своими произведениями на Джорджа Лукаса.

Другие авторы, в итоге, тоже подхватили идею, и стало появляться все больше роботов в научной фантастике, подчиняющихся трем законам. Но, по традиции, указывал их явно только Азимов.

Нередко можно встретить различные отсылки в фильмах. Ниже перечислены некоторые примеры.

Запретная планета — 1956 г.

Очень нашумевшая американская научно-фантастическая картинка 1950-х, оказала определенное влияние на развитие жанра. В этом фильме, чуть ли не впервые показали робота со встроенной системой безопасности, то есть, по сути, выполняющего три закона. Сам Азимов был доволен этим роботом.

Двухсотлетний человек — 1999 г.

Тут и нечего говорить, фильм поставлен по одноименному произведению Азимова. Однако, законы не имеют центрального места в сюжете.

Я, робот — 2004 г.

Фильм начинается со слов “По мотивам рассказов Айзека Азимова”. Здесь надо понимать, что он именно “по мотивам” и не повторяет ни один из рассказов, и даже ушел несколько в сторону в некоторых идеях, а также имеет ряд противоречий с рассказами. Но законы робототехники более чем на месте, хотя и были обдуманы сверх интеллектом в не лучшую для человека сторону. Сам по себе фильм даже ставит социально-философские проблемы: “стоит ли человеку за свою безопасность платить свободой” и “как нам себя вести, если существа, созданные нами и находящиеся в нашем распоряжении, потребуют свободы”.

Сам по себе фильм даже ставит социально-философские проблемы: “стоит ли человеку за свою безопасность платить свободой” и “как нам себя вести, если существа, созданные нами и находящиеся в нашем распоряжении, потребуют свободы”.

Серия фильмов «Чужие» и «Прометей»

Андроид Бишоп цитирует первый закон и явно создавался на некоем подобии законов Азимова.

Мультсериал «Футурама» — 1999 — 2013 г.

Робот Бендер мечтает убить всех людей, но не может этого сделать из-за законов робототехники.

Аниме сериал «Время Евы» — 2008 — 2009 г.

Небольшой аниме сериал про андроидов. В нем упоминаются эти законы, как обязательные для исполнения.

Применимость в реальном мире

Люди, которые сейчас занимаются проблемами искусственного интеллекта говорят, что, к сожалению, Азимовские законы остаются лишь идеалом для будущего, и на данный момент применить их на практике даже близко не представляется возможным. Нужно будет придумать действительно какую-то фундаментально новую и гениальную теорию, которая позволит эти законы не только «объяснить” роботам, но и заставить их следовать им, причем на уровне инстинктов. А это уже создание настоящего думающего существа, но с другой основой, нежели у всех живых существ на Земле, которые нам известны.

А это уже создание настоящего думающего существа, но с другой основой, нежели у всех живых существ на Земле, которые нам известны.

Но исследования ведутся, причем тема очень популярна. Особенно заинтересован в этом бизнес, который, как вы знаете, не обязательно будет ставить в приоритет меры безопасности. Но в любом случае, до создания системы общего искусственного интеллекта или хотя бы ее примитива, говорить о ее этике рано, а, уж тем более, навязывать свою. Понять как себя будет вести интеллект мы сможем только тогда, когда создадим его и проведем ряд экспериментов. Пока что у нас отсутствует объект, к которому эти законы можно было применить.

Ещё не стоит забывать, что законы сами по себе не были созданы совершенными. Они не работали даже в научной фантастике, и как вы помните, были специально такими сделаны.

В общем, будем ждать, следить за новостями в исследованиях ИИ, и надеяться что Азимовский оптимизм, по части роботов, будет оправдан.

Понравилась статья? Покажи её друзьям:

Правила для ИИ в реальном мире.

Законы робототехники Азимова устарели?

Законы робототехники Азимова устарели?

76 лет назад писатель-фантаст Айзек Азимов сформулировал три закона робототехники. На тот момент казалось, что они никогда не устареют. Насколько эти правила актуальны в современном мире, где искусственный интеллект закрепился во всех сферах жизни настолько прочно, что мы его даже не замечаем, пишет The Next Web.

Читать далее…

Три закона, которые Азимов впервые представил в научно-фантастическом рассказе «Хоровод», гласят:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Почти столетие Законы Азимова служили основой разработки роботов. Но эксперты считают, что они больше не соответствуют современным реалиям.

Но эксперты считают, что они больше не соответствуют современным реалиям.

Конечно, в 40-е никто не мог предвидеть появление Google и Facebook. Для людей того времени роботы — нечто с руками и лазерами, и уж никак не реклама в социальных сетях и поисковые алгоритмы. Роботы принимают всё более простую форму, и риск того, что они уничтожат человечество, отходит на дальний план. А на первое место выходит вопрос регулирования исследований в этой области. Политические деятели всей планеты призывают ведущих мировых экспертов не позволить машинам захватить мир.

Какими должны быть правила для искусственного интеллекта в реальном, а не фантастическом мире?

В феврале 2018 года специалисты организации Cambridge Consultants опубликовали доклад на тему возможностей ИИ «AI: Understanding And Harnessing The Potential». В нём они выделили пять ключевых правил, которыми должны руководствоваться учёные в своих исследованиях искусственного интеллекта, и которые также необходимо закрепить в законодательствах и на практике:

1. Ответственность: за результаты действий автономной системы должен нести ответственность определённый человек, не только потому, что он будет должен возместить ущерб, но и для того, чтобы обеспечить обратную связь, заниматься мониторингом последствий и вносить изменения в технологию.

Ответственность: за результаты действий автономной системы должен нести ответственность определённый человек, не только потому, что он будет должен возместить ущерб, но и для того, чтобы обеспечить обратную связь, заниматься мониторингом последствий и вносить изменения в технологию.

Не только в целях возмещения ущерба, но и для того, чтобы получить объяснение этих действий, отслеживать последствия, и вносить изменения.

2. Объяснимость: необходимо уметь объяснить простым людям (зачастую не разбирающемся в сфере) действия ИИ.

3. Точность: должно быть возможно идентифицировать, взять под контроль, оценить и по возможности исправить или устранить причины ошибки.

4. Прозрачность: результаты автономной системы должно быть возможным протестировать, описать в отчёте (публично или в частном порядке), вынести на обсуждение и оспорить результаты. Результаты испытаний и оценок следует обнародовать и объяснять.

5. Беспристрастность: использовать данные нужно разумно и не нарушая частных прав. Это поможет предотвратить предвзятость и различные неэтичные практики.

Стоит отметить, что здесь ничего не сказано об угрозе целенаправленного уничтожения человечества искусственным интеллектом. Возможно потому, что машины ещё не способны самостоятельно принимать такие решения.

Чтобы избежать опасностей, связанных с развитием искусственного интеллекта, стоит просто руководствоваться здравым смыслом. Вряд ли ИИ-алгоритму в основе Face ID Apple понадобится вас убивать, а вот безнравственный разработчик может запросто запрограммировать его на использование камеры вашего смартфона без вашего ведома.

Поэтому любые правила в отношении ИИ должны быть нацелены на то, чтобы предсказать возможный вред, снизить риск и обеспечить в первую очередь безопасность. Вот такой комплекс правил, например, разработала Google:

Мы выделили пять моментов, которые будут очень важны при использовании ИИ в более общих обстоятельствах.

Все они ориентированы на долгосрочную перспективу и будут иметь существенное значение в будущих в исследованиях, даже если сегодня кажутся незначительными:

1. Избежание негативных побочных эффектов: как гарантировать, что ИИ-система не начнёт разрушать окружающую среду, исполняя свои функции? Например, что робот-уборщик не перевернёт вазу, потому что так ему будет проще убирать?

2. Избежание самостимуляции: как избежать того, что робот просто начнёт искать самый лёгкий способ получить вознаграждение? Например, робот-уборщик не должен прикрывать беспорядок и делать вид, что его нет.

3. Самостоятельность: как гарантировать, что ИИ-система будет рационально использовать затратные ресурсы во время своего обучения? Например, если при выполнении задачи ИИ-системе требуется обратная связь от человека, то полученные вводные она должна использовать рационально, а не раздражать постоянными вопросами.

4. Безопасные открытия: как сделать так, чтобы ИИ-система не пострадала в процессе взаимодействия с миром? Например, робот может мыть пол, как ему угодно, но не должен совать влажную тряпку в розетку.

5. Устойчивость к изменениям: как сделать так, чтобы ИИ-система могла ориентировалась и продолжала действовать в обстановке, отличной от среды обучения? Например, методы уборки на фабрике неприменимы в офисе.

Будущее ИИ — проблема не только компаний вроде Google и Cambridge Consultants, ведь по мере внедрения машинного обучения во всё большее количество устройств, включая большинство смартфонов и компьютеров, она только усугубится. Зловредных программ может появиться всё больше, тем более что искусственный интеллект можно научить создавать гораздо более качественные алгоритмы, чем люди.

Вопросы контроля и морали в сфере искусственного интеллекта имеют мало отношения к роботам-убийцам, за исключением специально сконструированных военных машин. Вместо этого, правительствам стоит сосредоточиться на опасностях, которые ИИ представляет в повседневной жизни.

Вместо этого, правительствам стоит сосредоточиться на опасностях, которые ИИ представляет в повседневной жизни.

«Не убивать людей» — хорошее правило как для людей, так и машин независимо от их интеллектуального развития.

Последний закон робототехники :: Технологии и медиа :: Газета РБК

Подготовлен проект конвенции, регулирующей отношения искусственного интеллекта и людей

Отношения человека и искусственного интеллекта должны быть законодательно урегулированы, считают в Госдуме. В первой половине 2018 года профильный комитет рассмотрит проект конвенции о робототехнике и искусственном интеллекте

Фото: Michael Buholzer / Reuters

Комитет Госдумы по экономической политике, промышленности, инновационному развитию и предпринимательству рассмотрит конвенцию по робототехнике и искусственному интеллекту, рассказал РБК представитель Исследовательского центра проблем регулирования робототехники и искусственного интеллекта «Робоправо», разработавшего документ (есть в распоряжении РБК).

Председатель комитета Сергей Жигарев через помощника подтвердил эту информацию. Предполагаемый срок рассмотрения конвенции, а также формирования предложений законотворческих документов по теме «роботехника» — первое полугодие 2018 года. «Вопросы отношения человека и искусственного интеллекта — это вопросы, которые должны быть законодательно урегулированы в ближайшее время. После широкого общественного обсуждения с участием представителей экспертного, научного сообщества, а также представителей общественности документ поступит на рассмотрение в нижнюю палату парламента», — сообщил Жигарев.

Цель разработанной конвенции — определить основные проблемы, которые могут возникнуть в обществе и правовой системе в связи с активным развитием киберфизических систем, обобщить основные правила робототехники и обозначить возможные направления решения существующих и ожидаемых проблем, указано в документе.

Что предлагают авторы конвенции

- К объектам робототехники авторы документа относят все категории роботов в самом широком понимании независимо от их назначения, степени опасности, мобильности или автономности, а также киберфизические системы с искусственным интеллектом в любой форме.

- Авторы документа предлагают исходить из того, что «создание, внедрение и использование роботов должно осуществляться при условии максимального обеспечения безопасности человека, общества и государства, а также непричинения вреда человеку, человечеству, живым существам и всей их среде обитания».

- Роботы, создаваемые в военных целях, «должны иметь изначально заложенные в них и не поддающиеся изменениям ограничения, соответствующие положениям международного гуманитарного права». Такие роботы не должны использоваться для причинения вреда мирному населению.

- Предлагается установить повышенные требования к защите от несанкционированного доступа третьих лиц при эксплуатации роботов, потенциально способных причинить человеку существенный, в том числе смертельный, вред (медицинские роботы, имплантируемые устройства, высокоавтоматизированные транспортные средства, военные роботы и т.д.).

- Роботы должны постоянно фиксировать информацию об условиях своего функционирования и всех совершаемых ими действиях и хранить в специальном «черном ящике».

- Физически взаимодействующие с людьми и не находящиеся под прямым управлением человека роботы должны иметь функцию моментального или аварийного отключения по требованию («красную кнопку»).

- «Человек не должен умалять человеческое достоинство своим обращением с роботами».

Инвестиционный менеджер Фонда развития интернет-инициатив (ФРИИ) Никита Юрьев отмечает, что рынки роботов и искусственного интеллекта тесно взаимосвязаны — развитие первого невозможно без второго. «В свою очередь, рынок роботов создает широкие возможности для работы в направлении искусственного интеллекта: глубинного и машинного обучения, обработки естественного языка, машинного зрения», — отметил Юрьев. Он привел прогноз компании Grand View Research, согласно которому объем мирового рынка искусственного интеллекта в 2017 году должен составить около $19,18 млрд, а к 2025 году достигнет $35,9 млрд.

Рынок роботов только в сфере услуг должен достичь $27,5 млрд к 2023 году при среднем темпе роста 15,18% в год, приводит Юрьев данные компании MarketsandMarkets. Рынок роботов в производстве к этому же сроку должен достичь $71,72 млрд. При этом суммарно мировые расходы на роботов, по данным IDC, должны уже к 2019 году превысить $135,4 млрд. «Лидером в данном направлении считают Азиатско-Тихоокеанский регион, а одним из самых ярких игроков — Boston Dynamics (американская инжиниринговая компания, некоторое время принадлежавшая Google, сейчас принадлежит SoftBank. — РБК)», — рассказал представитель ФРИИ.

Рынок роботов в производстве к этому же сроку должен достичь $71,72 млрд. При этом суммарно мировые расходы на роботов, по данным IDC, должны уже к 2019 году превысить $135,4 млрд. «Лидером в данном направлении считают Азиатско-Тихоокеанский регион, а одним из самых ярких игроков — Boston Dynamics (американская инжиниринговая компания, некоторое время принадлежавшая Google, сейчас принадлежит SoftBank. — РБК)», — рассказал представитель ФРИИ.

Проект конвенции, разработанный «Робоправом», не первая попытка законодательно урегулировать рынок искусственного интеллекта. В декабре 2016 года «Ведомости» сообщили, что основатель Grishin Robotics и сооснователь Mail.Ru Group Дмитрий Гришин совместно с юристом Виктором Наумовым разработали концепцию закона о робототехнике.

Фото: TPG / Zuma / TAСС

Этот законопроект предлагает дополнить Гражданский кодекс главой о роботах-агентах, то есть тех роботах, которые могут действовать автономно. «Мы продолжаем активное обсуждение законодательных инициатив в этой области, по разным оценкам экспертов, рынок искусственного интеллекта к 2020 году вырастет до $5 млрд», — передал Гришин РБК через представителя.

«Мы продолжаем активное обсуждение законодательных инициатив в этой области, по разным оценкам экспертов, рынок искусственного интеллекта к 2020 году вырастет до $5 млрд», — передал Гришин РБК через представителя.

Исследовательский центр «Робоправо» создан как автономная некоммерческая организация в начале 2017 года по инициативе сотрудников международной юридической фирмы Dentons Андрея Незнамова и Виктора Наумова, рассказал РБК представитель центра. По его словам, разработанные по заказу Гришина поправки стали «толчком к созданию конвенции». В то же время он отметил, что законопроект и конвенция практически не пересекаются по смыслу. «Появление «закона Гришина» инициировало широкое обсуждение вопросов регламентации робототехники. В совокупности с этими и другими факторами встал вопрос о принятии законов о робототехнике вообще, а не только внесении изменений в Гражданский кодекс», — отметил он.

Как пояснил представитель центра «Робоправо», многие эксперты в мире говорят о необходимости создания общего свода правил взаимодействия человека с роботами и искусственным интеллектом. «Мы решили попытаться сделать это. Проанализировали существующие законы и правила. Постарались их обобщить, а также сделать ряд новых предложений, не претендуя на исчерпываемость и окончательность», — отметил он.

«Мы решили попытаться сделать это. Проанализировали существующие законы и правила. Постарались их обобщить, а также сделать ряд новых предложений, не претендуя на исчерпываемость и окончательность», — отметил он.

Как в мире юридически регулируют искусственный интеллект

На данный момент в мире практически не существует специальных законодательных актов, определяющих статус машин с искусственным интеллектом. В США, например, рассмотрение возникающих споров по этой проблеме основывается на действующих общих законах, что зачастую вызывает трудности при рассмотрении дел в суде.

Специальный закон о робототехнике был принят в 2008 году в Южной Корее. Несмотря на то что в акте «О содействии развитию и распространению умных роботов» фактически не идет речи о регулировании искусственного интеллекта, а в качестве основной его цели было заявлено стимулирование робототехники и улучшение качества жизни граждан, в документе дается несколько важных определений. Под термином «умный робот» южнокорейские законодатели предлагают понимать «механическое устройство, которое самостоятельно воспринимает внешнюю среду, распознает обстоятельства, в которых работает, и движется самостоятельно». В одной из статей закона говорится, что в будущем правительство имеет право принять специальный закон, регулирующий этические нормы развития робототехники, которым должны следовать разработчики, производители и пользователи умных роботов.

Под термином «умный робот» южнокорейские законодатели предлагают понимать «механическое устройство, которое самостоятельно воспринимает внешнюю среду, распознает обстоятельства, в которых работает, и движется самостоятельно». В одной из статей закона говорится, что в будущем правительство имеет право принять специальный закон, регулирующий этические нормы развития робототехники, которым должны следовать разработчики, производители и пользователи умных роботов.

Первые шаги в этом направлении делают и в Европе. В феврале 2016 года Европарламент принял резолюцию «Нормы гражданского права в робототехнике», в которой парламентарии обратили внимание на важность развития законодательной базы, а также отметили необходимость введения единой системы классификации роботов и общеевропейской системы их регистрации. Большое внимание в документе уделяется этическим принципам: например, отмечается, что потенциал использования робототехники должен оцениваться с точки зрения отсутствия угроз безопасности и здоровью человека, свободе и неприкосновенности частной жизни.

В ходе саммита ЕС, который прошел в Брюсселе в октябре 2017 года, лидеры европейских стран договорились в начале 2018 года разработать европейский подход к проблеме искусственного интеллекта. В официальных документах саммита также говорилось о необходимости активнее реагировать на новые мировые тенденции, к которым относится развитие искусственного интеллекта.

Приемная комиссия УГАТУ

Направление подготовки бакалавров

15.03.06 «Мехатроника и роботехника»

Подробная информация о направлениях и специальности подготовки размещена

на Портале абитуриентов ИАТМ УГАТУ

vk.com/abiturienty_iatm_ugatu

Выпускающая кафедра: кафедра автоматизации технологических процессов (АТП) Института авиационных технологий и материалов (ИАТМ).

Срок обучения: очная форма — 4 года.

Область профессиональной деятельности?

Мехатроника — область науки и техники, основанная на системном объединении узлов точной механики, датчиков состояния внешней среды и самого объекта, источников энергии, исполнительных механизмов, усилителей, вычислительных устройств (ЭВМ и микропроцессоры).

Мехатронная система — единый комплекс электромеханических, электрогидравлических, электронных элементов и средств вычислительной техники, между которыми осуществляется постоянный обмен энергией и информацией, объединенный общей системой автоматического управления, обладающей элементами искусственного интеллекта.

Роботы и робототехнические системы, создаваемые на базе мехатронных модулей, предназначены для выполнения рабочих операций от микро- до макроразмерностей, в том числе с заменой человека на тяжелых, утомительных и опасных работах.

Чему Вас научат?

— Выпускники направления смогут создавать и эксплуатировать сложные мехатронные автоматические и автоматизированные системы, в том числе роботы и роботизированные системы и комплексы.

— Разрабатывать математическое, алгоритмическое, программное и информационное обеспечение данных систем для использования их в различных отраслях современной промышленности, в том числе оборонной, машиностроительной, приборостроительной, энергетике, транспорте, медицине и сельском хозяйстве.

Где могут работать выпускники?

В рамках направления кафедра обеспечивает рынок труда востребованными высококвалифицированными кадрами в области проектирования и эксплуатации мехатронного станочного оборудования, сложных мехатронных и робототехнических систем.

По информации с базы работодателей и партнеров УГАТУ (http://ugatu.su/jobugatu) выпускников направления ждут:

- ООО «ДБА — Инжиниринг», г.

Уфа;

Уфа; - ООО «Автоцентр Керг» г.Уфа;

- ОАО «УАП «Гидравлика», г. Уфа;

- ОАО «Уралтехнострой-Туймазыхиммаш;

- ОАО «Уфимское агрегатное производственное объединение»;

- Открытое акционерное общество «Башкирское производственное объединение «Прогресс», г. Уфа;

- Центр коллективного доступа радиоэлектронного кластера Республики Башкортостан;

- Группа компаний «Искра-Про», г.Уфа;

- ООО «Сферра», г. Уфа;

- ООО ИЭЦ Трубопроводсервис, г. Уфа;

- Компания Schlumberger Logelco Inc.;

- ОАО «Научно-исследоват. проектно-конструкторский и технологич. инс-тут электромашиностроения» (НИПТИЭМ), г. Владимир;

- ОАО «КАМАЗ»;

- ООО Глобал Ресторантс, г. Уфа;

- ООО НПФ «Экситон-автоматика»;

- ООО «РУСЭЛПРОМ», г. Москва;

- ООО ОйлГИС, г. Уфа;

- ООО «Школа Kingsman», г. Уфа;

- ООО «Крезол», г.

Уфа;

Уфа; - ООО «ЭРА Групп», г. Уфа;

- ООО «НАУЧНО-ИССЛЕДОВАТЕЛЬСКИЙ И ПРОЕКТНЫЙ ИНСТИТУТ ПО ОБУСТРОЙСТВУ НЕФТЯНЫХ И ГАЗОВЫХ МЕСТОРОЖДЕНИЙ», г. Уфа;

- ОАО «Сарапульский электрогенераторный завод»;

- ООО «Нефтепромавтоматика», г. Уфа;

- Кадровое агентство «Триумф»;

- и др.

Выпускники составляют основной инженерно — технический состав предприятий, работают на должностях конструкторов, технологов, механиков, специалистами IT-технологий.

После окончания бакалавриата возможно продолжение обучения в магистратуре по аналогичному направлению «Мехатроника и робототехника» (срок обучения — 2 года).

Научно-исследовательское студенческое конструкторское объединение «Промышленная электроника и робототехника»

Студенческое конструкторское бюро Промышленная электроника и робототехника состоит из энтузиастов-изобретателей, будущих ученых, кандидатов и профессоров технических наук. Специалисты и бакалавры технического уровня, инженеры и техники занимаются мобильной робототехникой и промышленной электроникой. Исследователи реализуют проекты в области автоматизации и роботизации промышленности. Мы обмениваемся информацией необходимой для работы научного метода в области 3D моделирования и печати, проектирования, лазерной резки и станков с ЧПУ.

Специалисты и бакалавры технического уровня, инженеры и техники занимаются мобильной робототехникой и промышленной электроникой. Исследователи реализуют проекты в области автоматизации и роботизации промышленности. Мы обмениваемся информацией необходимой для работы научного метода в области 3D моделирования и печати, проектирования, лазерной резки и станков с ЧПУ.

Основными направлениями деятельности являются:

- создание и развитие условий, которые обеспечат возможность для каждого студента реализовать свое право на развитие личности, на участие в научных исследованиях и научно-техническом творчестве;

-

обеспечение единства образовательного, научного и инновационного процессов с формированием и развитием способностей, улучшением профессиональной подготовки студентов, совершенствованием форм привлечения молодежи к научным исследованиям, научно-технической, изобретательской и рационализаторской деятельности. -

создание благоприятных условий для развития и функционирования различных форм научного творчества молодежи, базирующихся на отечественном и зарубежном опыте, результатах научных и научно-технических разработок; -

содействие всестороннему развитию личности студента, формированию его объективной самооценки, приобретению навыков работы в коллективах, приобщению к организаторской и инновационной деятельности; -

развитие способности использовать научные знания и быстро адаптировать при изменении ситуации, готовности к повышению квалификации и переподготовке; -

предоставление студентам возможности испробовать свои силы в решении актуальных задач по различным направлениям науки и техники, опубликовать значимые результаты исследований.

Достижения научного объединения за 2018-2019 гг.

группа в VK : https://vk.com/cmitirkutsk

«HELLO, ROBOT!» LEGO®

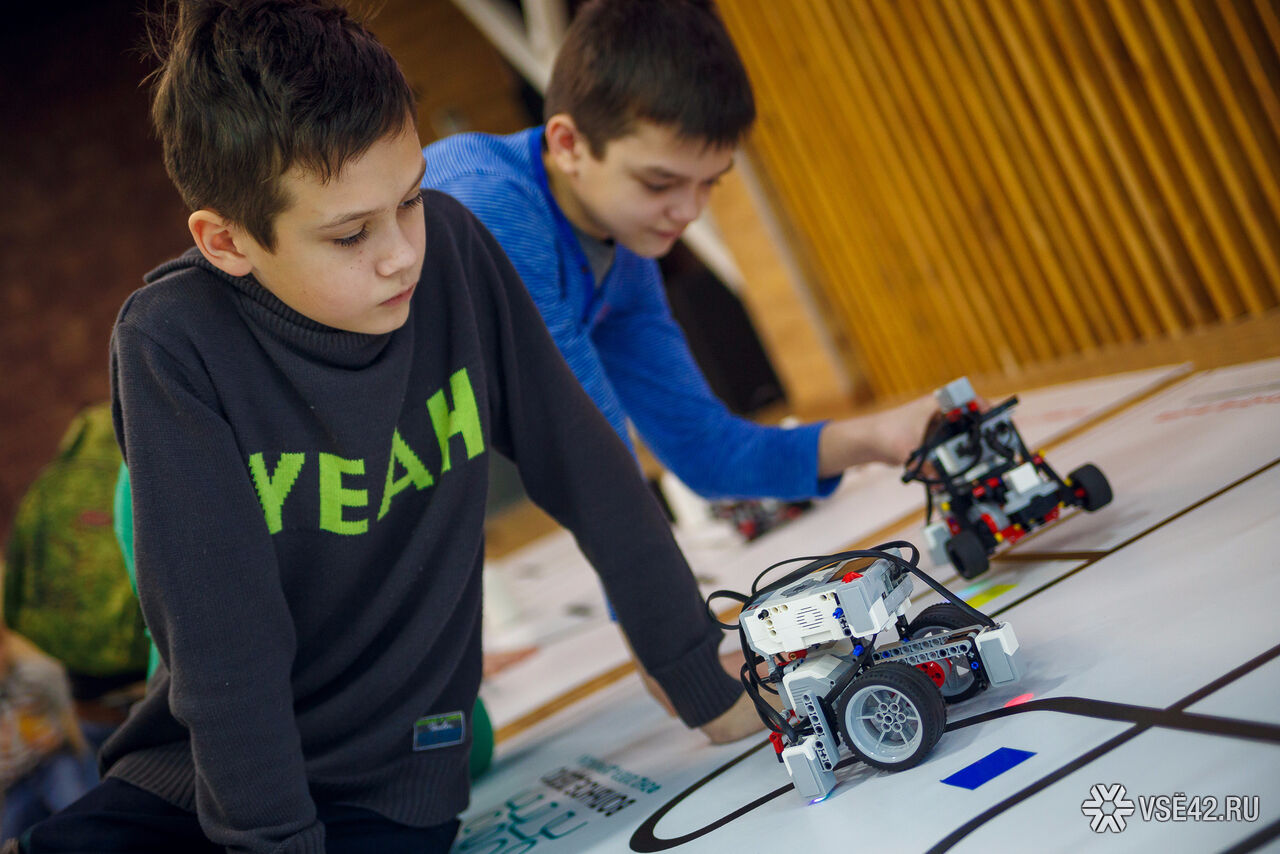

Команда: коллектив учащихся из 2-х человек во главе с тренером, осуществляющие занятия по робототехнике (подготовку к состязаниям) в рамках образовательного учреждения или самостоятельно (семейные или дворовые команды). Возраст (класс) участников команды

определяется на момент проведения соревнований.

Минимальный возраст тренера команды: 18 лет.

Уважаемые участники направления «Hello, Robot! LEGO»!

Соревнования предназначены для участников первого-второго года обучения, не принимавших участие в региональных и всероссийских соревнованиях по робототехнике прошлых сезонов на базе конструкторов LEGO Mindstorms (наборы 45544, 45560, 9797, 9695).

Соревнования состоятся в ОДИН из дней технологического фестиваля РОБОФЕСТ-2021 по дополнительно объявленному расписанию и по объявленным категориальным правилам. Также предполагается дистанционная форма соревнований.

Правила могут измениться. Окончательная версия правил будет опубликована на сайте фестиваля не позднее, чем за 2 недели до даты его проведения. В день соревнований Главным судьей может быть сформулировано дополнительное задание не меняющее общий регламент соревнований и объявленное всем участникам не позднее чем за 2 часа до начала заездов.

Регламенты нового сезона опубликованы ниже.

Будем рады ответить на ваши вопросы по регламентам в группе Telegram:

https://t.me/joinchat/P5UDMRX-2sNcqHZfLmUClQ или по электронной почте [email protected] .

И подписывайтесь на канал “РобоФест-2021.Онлайн” в Telegram:

https://t.me/robofest_online

______________________________________________________________________________________________________________________________________________

Серия соревновательных и образовательных мероприятий под названием «Hello, Robot!», была создана Программой «Робототехника» с целью вовлечения новых участников в комплекс учебно-тренировочных и спортивных мероприятий Всероссийской Программы «Робототехника: инженерно-технические кадры инновационной России».

Образовательный модуль посвящен подготовке потенциальных и начинающих преподавателей образовательной робототехники (в школах, кружках дополнительного образования, центрах технического творчества) к ведению занятий с детьми и подготовке их к участию в первой ступени соревнований.

Соревнования проводятся в одной возрастной группе по следующим направлениям:

Младшая – учащиеся 2-4 классов:

● «РобоИсполнитель».

Старшая – учащиеся 5-6 классов:

● «Робо».

Все вопросы по регламенту «Hello, Robot!» на почту [email protected]

Законы Азимова не остановят роботов от причинения вреда людям, поэтому мы разработали лучшее решение

Следующее эссе перепечатано с разрешения The Conversation, онлайн-публикации, посвященной последним исследованиям.

Как сделать так, чтобы робот не причинял вреда людям? Многие существующие роботы, например, собирающие автомобили на заводах, сразу отключаются, когда приближается человек. Но это быстрое решение не сработает для чего-то вроде беспилотного автомобиля, которому, возможно, придется двигаться, чтобы избежать столкновения, или робота для ухода, которому, возможно, придется поймать старика, если он упадет.Поскольку роботы должны стать нашими слугами, товарищами и сотрудниками, нам необходимо иметь дело со все более сложными ситуациями, которые это создаст, а также с вопросами этики и безопасности, которые это вызовет.

Научная фантастика уже предвидела эту проблему и предлагала различные возможные решения. Самым известным из них были «Три закона робототехники» Исаака Азимова, которые призваны предотвратить нанесение роботами вреда людям. Но с 2005 года я и мои коллеги из Университета Хартфордшира работали над идеей, которая могла бы стать альтернативой.

Вместо законов, ограничивающих поведение роботов, мы думаем, что роботы должны быть уполномочены максимально использовать возможные способы их действий, чтобы они могли выбрать лучшее решение для любого заданного сценария. Как мы описываем в новой статье в Frontiers, этот принцип может лечь в основу нового набора универсальных рекомендаций для роботов по обеспечению максимальной безопасности людей.

Три закона

Три закона Азимова:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам людей, за исключением случаев, когда такие приказы противоречат Первому Закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Хотя эти законы кажутся правдоподобными, многочисленные аргументы показали, почему они неадекватны. Истории самого Азимова, возможно, представляют собой деконструкцию законов, показывая, как они постоянно терпят неудачу в различных ситуациях.Большинство попыток разработать новые руководящие принципы следуют аналогичному принципу для создания безопасных, совместимых и надежных роботов.

Одна проблема с любыми четко сформулированными руководящими принципами для роботов — необходимость их перевода в формат, с которым могут работать роботы. Понимание всего диапазона человеческого языка и опыта, который он представляет, — очень сложная работа для робота. Общие поведенческие цели, такие как предотвращение причинения вреда людям или защита существования роботов, могут означать разные вещи в разных контекстах.Соблюдение правил может в конечном итоге оставить робота беспомощным, чтобы действовать так, как могли надеяться его создатели.

Наша альтернативная концепция, расширение прав и возможностей, означает противоположность беспомощности. Быть уполномоченным означает иметь возможность влиять на ситуацию и осознавать, что вы можете это сделать. Мы разрабатываем способы перевода этой социальной концепции на поддающийся количественной оценке и оперативный технический язык. Это наделит роботов стремлением держать свои возможности открытыми и действовать таким образом, чтобы усилить их влияние на мир.

Когда мы попытались смоделировать, как роботы будут использовать принцип расширения прав и возможностей в различных сценариях, мы обнаружили, что они часто будут действовать удивительно «естественным» образом. Обычно от них требуется только моделирование того, как работает реальный мир, но не требуется никаких специализированных программ искусственного интеллекта, предназначенных для работы с конкретным сценарием.

Но чтобы обезопасить людей, роботы должны стараться поддерживать или улучшать человеческие возможности, а также свои собственные. По сути, это означает защиту и поддержку.Открытие запертой двери для кого-то увеличило бы его возможности. Их ограничение приведет к кратковременной потере полномочий. А причинение им значительного вреда могло полностью лишить их полномочий. В то же время робот должен попытаться сохранить свои собственные возможности, например, убедившись, что у него достаточно мощности для работы, и он не застрянет или не повредится.

Роботы могут адаптироваться к новым ситуациям

Использование этого общего принципа, а не предопределенных правил поведения позволило бы роботу учитывать контекст и оценивать сценарии, которые ранее никто не предполагал.Например, вместо того, чтобы всегда следовать правилу «не толкать людей», робот, как правило, избегает толкать их, но все же сможет оттолкнуть их с пути падающего объекта. Человек все равно может пострадать, но в меньшей степени, чем если бы его не толкнул робот.

В фильме «Я, робот», основанном на нескольких историях Азимова, роботы создают угнетающее состояние, которое должно минимизировать общий вред людям, удерживая их взаперти и «защищая». Но наш принцип позволит избежать такого сценария, потому что это будет означать потерю прав и возможностей человека.

Хотя расширение прав и возможностей позволяет по-новому взглянуть на безопасное поведение роботов, нам еще предстоит проделать большую работу по повышению его эффективности, чтобы его можно было легко развернуть на любом роботе и превратить в хорошее и безопасное поведение во всех отношениях. Это представляет собой очень сложную задачу. Но мы твердо верим, что расширение прав и возможностей может привести нас к практическому решению текущей и широко обсуждаемой проблемы о том, как обуздать поведение роботов и как сохранить роботов — в самом наивном смысле — «этичными».

Эта статья изначально была опубликована на сайте The Conversation. Прочтите оригинальную статью.

СПЕКУЛЯТИВНАЯ НАУКА Каковы три закона робототехники Исаака Азимова? Являются ли они чисто вымышленными или им можно доверять? Пол Питерс, Тоттенхэм, Великобритания

Добавьте свой ответ |

Законы о роботах: 5 новых правил, которые могут спасти человеческие жизни (по крайней мере, на телевидении)

От Battlestar Galactica до The Terminator , экранные роботы никогда не были выше небольшого нарушения правил. Могут ли наши новые законы робототехники сдержать их?

Технология

2 августа 2018 г.

Автор Галаад Амит

Как вы должны себя вести, если вы робот? По словам писателя-фантаста Айзека Азимова, есть три простых правила: не позволять людям причинять вред, подчиняться приказам и защищать себя — в указанном порядке приоритета.

Азимов впервые изложил эти три закона робототехники в своем рассказе 1942 года Runaround , но с тех пор они стали основными в жанре, нарушаемым искусственным интеллектом во всем, от Doctor Who до Alien . Однако по мере того, как они продолжают доминировать в разговоре, законы Азимова быстро устаревают.

В конце концов, мы живем в мире, который быстро заполняется настоящими роботами: водят наши машины, выполняют медицинские процедуры, влияют на наши выборы и угрожают лишить нас работы.Может ли новый свод законов защитить нас?

Имея это в виду, мы составили пересмотренный набор законов, чтобы помочь нам жить бок о бок с искусственным интеллектом в 21 -м веке (чтобы узнать больше, см. «Законы о роботах: зачем нам кодекс поведения для ИИ — и быстро »). Будут ли они по-прежнему созданы для развлекательной научной фантастики? Обратите внимание, спойлеры следуют…

Gary Hutzel / NBC / NBCU Photo Bank via Getty

Пресловутые цилоны Battlestar Galactica , которые уничтожили большую часть человечества, прежде чем преследовать выживших по всей галактике, определенно нарушили бы наш первый закон: робот не может причинить вред человеку или позволить человеку причинить вред — если только он не находится под наблюдением другого человека .

MGM / Stanley Kubrick Productions / Kobal / REX / Shutterstock

В 2001: A Space Odyssey судовой бортовой компьютер HAL 9000 обрекает свою команду по причинам, которые остаются неясными. Это противоречит нашему второму закону: робот должен уметь объяснять себя . Не обязательно устно или даже явно, но с помощью прозрачного кода, чтобы сделать его действия и мотивацию ясными.

Columbia / Kobal / REX / Shutterstock

Женщины-роботы из Stepford Wives 1975 года созданы для воплощения сексистского идеала женского поведения.Если мы хотим убедиться, что машины будущего не увековечивают наши собственные человеческие предрассудки, то важно научить их подниматься над мелкими стереотипами, которые определяют многие наши собственные мысли и действия. Говоря словами нашего третьего закона: робот должен относиться ко всем людям одинаково .

PictureLux / eyevine

Одноименный тематический парк, где разворачивается телешоу Westworld , основан на сложных роботах, неотличимых от людей.Фактически, по мере развития сериала различие становится все более размытым. Ничего из этого не допускается нашим четвертым законом: робот не должен выдавать себя за человека .

Moviestore Collection / REX / Shutterstock

Стреляйте в них, замораживайте их, разбивайте на части: роботов Terminator практически не остановить. Если мы хотим, чтобы роботы оставались на своей полосе движения, нам необходимо ввести наш пятый закон: у робота всегда должен быть выключатель .

Еще по этим темам:

Новые законы робототехники — основанные на наследии научной фантастики Азимова в эпоху искусственного интеллекта

Еще в начале 1940-х годов — задолго до смартфонов, Siri и полуавтономного оружия — конца великой науки -fi писатель Исаак Азимов разработал набор принципов для разработки передовых робототехнических систем.

Азимов был по сути оптимистом, но он понимал, что будущим устройствам искусственного интеллекта и их разработчикам может потребоваться небольшая помощь, чтобы оставаться на верном пути.

Отсюда его знаменитые «Три закона», которые по сей день имеют влияние в научных и технических кругах.

- 1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- 2. Робот должен подчиняться приказам людей, за исключением случаев, когда такие приказы противоречат Первому закону.

- 3. Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Теперь, почти 80 лет спустя, ученый-юрист и эксперт по искусственному интеллекту Фрэнк Паскуале добавил четыре дополнительных принципа.

Он рассказал о подкасте Future Tense от RN. Вот что вам нужно знать.

Что сделал Азимов не так?

Профессор Паскуале говорит, что, хотя идеи Азимова были хорошо обоснованы, они приняли определенную технологическую траекторию, которая больше не актуальна — инновации не всегда идут на благо человечества.

«В то время как Азимов говорит о том, что роботы помогают людям, а не вредят им, я говорю о том, как мы демократизируем направление развития технологий», — говорит он.

И он проводит важное различие между ИИ и тем, что он называет ИА — увеличением интеллекта.

«Цель искусственного интеллекта часто состоит в том, чтобы заменить людей, создать, например, робота-врача или робота-учителя. Цель увеличения интеллекта — помочь людям».

Итак, какие новые законы и зачем они нужны?

Профессор Паскуале говорит, что рабочие места, предполагающие осмысление и обдумывание выбора, должны оставаться за людьми. (

Getty: Donald Iain Smith

)

Профессор Паскуале говорит, что ставки высоки.

Оптимальное сочетание взаимодействия роботов и человека слишком важно, чтобы его могли определять только корпорации и инженеры, — утверждает он.

«Если мы будем придерживаться концепции искусственного интеллекта замены, это создаст будущее без работы во многих областях», — говорит он.

«Принимая во внимание, что если мы сделаем упор на увеличение интеллекта, это должно фактически повысить как производительность, так и стоимость труда».

Новый закон 1: ИИ должен дополнять профессионалов, а не заменять их

Профессор Паскуале говорит, что в некоторых сферах экономики, особенно в производстве, по-прежнему будет происходить быстрая автоматизация, но рабочие места, предполагающие осмысление и обдумывание выбора, должны оставаться за людьми. .

«В таких областях, как преподавание, медицина и многие другие профессиональные области, вы хотите, чтобы люди могли объяснять варианты действий своим клиентам, пациентам и студентам, вместо того, чтобы какая-то крупная техническая фирма просто предполагала, что лучше, и автоматизировала результат. »

Может ли робот делать вашу работу?

Найдите в нашей базе данных все профессии в Австралии, чтобы узнать, насколько сложно искусственному интеллекту выполнять вашу работу.

Подробнее

Но он подчеркивает необходимость распознавать тех, кого технология делает ненужными, и помогать им.

«Часть упрощения состоит в том, чтобы вкладывать средства в людей и подчеркивать, что каждый может играть определенную роль в обществе, предполагающую работу с суждениями, а их опыт будет ценным для этой работы».

Новый закон 2: Роботизированные системы и искусственный интеллект не должны подделывать человечество

Устройства не должны разрабатываться для имитации человеческих эмоций.

Профессор Паскуале говорит, что, хотя личные помощники, такие как Сири, могут показаться доброжелательными, они рискуют обмануть людей и манипулировать нашими чувствами.

Будущее взаимодействия человека с компьютером будет связано с жесткими суждениями о том, насколько бесшовным должно быть личное взаимодействие с роботами, и нужно ли иметь какое-то трение для создания определенного уровня дистанции.

Профессор Паскуале также утверждает, что нам нужно быть более дисциплинированными в языке, который мы используем в робототехнике.

«Я сопротивляюсь тому, чтобы даже романисты или писатели-беллетристы называли робота« он »или« она », как человек. Я думаю, что« это »всегда должно быть местоимением, потому что я думаю, что« оно »как бы обозначает тот факт, что это машина и это не человек.»

Погрузитесь глубже: Что наши виртуальные помощники говорят о сексизме? Оказывается, довольно много.

Новый закон 3: Роботизированные системы и ИИ не должны усиливать гонку вооружений с нулевой суммой

Непроверенный Профессор Паскуале предупреждает, что разработка интеллектуальных систем роботизированного оружия рискует выйти из-под контроля.

И, учитывая наш послужной список с другими военными расходами, есть все основания предполагать, что из-за разработки и развертывания оружия ИИ будет развиваться гонка вооружений.

Слушайте подкаст

Future Tense исследует новые идеи и новые технологии.

Подробнее

«Я думаю, что с самого начала мы должны сказать, как мы заставляем общества признать, что это разрушительно, что это не оказывает реальных человеческих услуг, а просто инвестирует в историю разрушения», — говорит профессор Паскуале.

Он также предостерегает от участия технологических компаний, таких как Google и Facebook, в «гонке вооружений за внимание» как среди рекламодателей, так и среди пользователей платформы.

Гиперконкурентоспособность, предупреждает он, — это путь к «технологическому господству и монополизации».

По теме: Силы обороны Австралии инвестируют миллионы в исследования «роботов-убийц».

Новый закон 4: Роботизированные системы и ИИ всегда должны указывать личность их создателя (ей), контроллера (ов) и владельца (ов)

Требуется более высокий уровень прозрачности для повышения ответственности и предотвращения несоответствующей и незаконной деятельности путем как владельцы, так и разработчики технологий.

Роботы тоже должны иметь номерные знаки, как автомобили, — говорит профессор Паскуале.

Он считает, что ни одна роботизированная система никогда не должна быть полностью автономной. По его словам, риски слишком высоки.

«Это важно, потому что мы знаем, как наказывать людей, мы не знаем, как наказывать роботов или ИИ, и это действительно важно для будущего правоприменения».

Вы решаете: позволите ли вы автомобилю определять, кто умирает?

Но разве это не остановит инновации?

Короткий ответ — да.

Профессор Паскуале признает, что широкое применение его новых законов остановило бы развитие определенных технологий, но, по его словам, это будет на благо общества.

Читать дальше Future Tense

«Мы видели так много областей, в которых технический прогресс привел к очень тревожным и пагубным последствиям, таким как глобальное потепление. Мы должны опередить эти вещи», — говорит он.

«Мы не можем просто взглянуть на что-то вроде глобального потепления и сказать: ну, мы просто исправим это технологически.

«Мы должны очень глубоко задуматься о направлении инноваций, а сами инновации не могут быть просто лозунгом для прекращения регулирования».

Эти законы подробно описаны в книге профессора Паскуале «Новые законы робототехники: защита человеческого опыта в эпоху искусственного интеллекта». Чтобы услышать полное интервью, послушайте подкаст Future Tense.

RN в вашем почтовом ящике

Получайте больше новостей, выходящих за рамки цикла новостей, с нашим еженедельным информационным бюллетенем.

Четвертый закон Робототехники Азимова

Как и я, я уверен, что многие из вас, ботаники, читали книгу «Я, робот.«Я, робот» — это основополагающая книга, написанная Исааком Азимовым (на самом деле это была серия книг, но я читал только одну), в которой исследуются моральные и этические проблемы, создаваемые миром, в котором доминируют роботы.

Но я прочитал эту книгу около 50 лет назад, так что фильм «Я, робот» с Уиллом Смитом на самом деле более актуален для меня сегодня. В фильме хорошо обсуждаются этические и моральные проблемы, связанные с обществом, в котором роботы играют такую доминирующую и решающую роль в повседневной жизни.И книга, и фильм вращаются вокруг «Трех законов робототехники», а именно:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат Первому Закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит первому или второму закону.

Это как «3 заповеди» робота; соблюдайте эти три закона и все будет хорошо.К сожалению, это оказалось неправдой (если 10 заповедей не могут эффективно управлять людьми, как мы можем ожидать, что только 3 будут управлять роботами?).

В фильме есть сцена, где детектив Спунер (которого играет Уилл Смит) объясняет доктору Кэлвину (который отвечает за поведение роботов, похожее на человеческое), почему он не доверяет и ненавидит роботов. Он описывает инцидент, когда его полицейская машина врезалась в другую машину, и обе машины были брошены в холодную и глубокую реку — верная смерть для всех пассажиров.Однако робот прыгает в воду и решает спасти детектива Спунера над 10-летней девочкой (Сарой), которая была в другой машине. Вот диалог между детективом Спунером и доктором Кальвином о решении робота спасти детектива Спунера вместо девушки:

Доктор Кальвин : «Мозг робота — это двигатель различий [1]. Он считывает показатели жизнедеятельности и, должно быть, рассчитал, что… »

Spooner : «Да… Я был логичным выбором, чтобы спасти.Было подсчитано, что у меня был шанс выжить 45%. У Сары был только 11% шанс. Она была чьим-то ребенком. 11% более чем достаточно. Человек знал бы это ».

Недавно я разговаривал через LinkedIn (видите, не все разговоры в социальных сетях полны фейковых новостей) с Фабио Чуччи, основателем и генеральным директором Anfy srl из Лукки, Тоскана, Италия, об искусственном интеллекте и вопросах этики. Фабио предложил мне следующий сценарий:

«Предположим, что в мире автономных автомобилей двое детей внезапно бегут перед автономным автомобилем с единственным пассажиром, и автономный автомобиль (робот) вынужден принимать незыблемое решение или выбор относительно того, кого убить, а кого пощадить (дети против водителя).”

Какое решение принимает автономный (роботизированный) автомобиль? Похоже, Айзек Азимов не предполагал, что нужен закон, чтобы управлять роботами в таких ситуациях жизни и смерти, когда спор идет не о жизни робота, а о жизни человека, а о выборе между жизнями. нескольких людей!

Был проведен ряд исследований, чтобы понять, что делать в ситуации, когда автономный автомобиль должен принять решение не на жизнь, а на смерть: спасти водителя или щадить пешеходов.Из статьи «Будет ли ваш беспилотный автомобиль готов убить вас, чтобы спасти жизни других?» получаем следующее:

«В одном опросе 76% людей согласились с тем, что беспилотный автомобиль должен приносить в жертву своего пассажира, а не врезаться в 10 пешеходов и убить их. Они также согласились с тем, что такое программирование автономных транспортных средств является моральным: это сводит к минимуму количество смертей, вызванных автомобилями. И этот вид сохранялся даже тогда, когда людей просили представить себя или члена семьи, путешествующими в машине.”

Хотя 76%, конечно, не подавляющее большинство, похоже, есть основа для создания 4-го закона робототехники для управления такого рода ситуациями. Но подождите, хотя теоретически 76% предпочитают спасать пешеходов водителю, настроение меняется, когда речь идет о ВАС!

«Когда людей спросили, купят ли они машину, управляемую таким моральным алгоритмом, их энтузиазм остыл. Опрошенные сказали, что предпочли бы купить машину, запрограммированную на самозащиту, а не пешеходов.Другими словами, беспилотные автомобили, которые иногда жертвуют водителями ради общего блага, были прекрасной идеей, но только для других людей ».

Похоже, Мерседес уже приняла решение, кого убить, а кого пощадить. В статье «Почему решение Mercedes позволить своим самоуправляемым автомобилям убивать пешеходов, вероятно, является правильным делом», Mercedes программирует свои автомобили так, чтобы спасти водителя и убить пешеходов или другого водителя в этих несвоевременных условиях. нерешительные, жизненно важные решения.Разгадай мне эту загадку, Бэтмен: повлияет ли то, как автономный автомобиль «запрограммирован» на реакцию в этих жизненно важных ситуациях, на ваше решение купить автономный автомобиль определенной марки?

Другое исследование, опубликованное в журнале «Science» (Социальная дилемма автономных транспортных средств), выявило этические дилеммы, с которыми сталкиваются производители беспилотных автомобилей, и то, что люди считали правильным курсом действий; убить или быть убитым. Было опрошено около 2000 человек, и большинство из них считало, что автономные автомобили всегда должны принимать решение, вызывающее наименьшее количество смертей.С другой стороны, большинство людей также сказали, что купят один только в том случае, если это будет означать, что их безопасность является приоритетом.

Четвертый закон робототехники

Исторически отношения человека и машины были отношениями хозяин / раб; мы сказали машине, что делать, и она сделала это. Но сегодня, благодаря искусственному интеллекту и машинному обучению, машины становятся равными нам в решении растущего числа задач.

Я понимаю, что в целом автономные транспортные средства спасают жизни… много жизней. Но будут ситуации, когда эти машины будут вынуждены принимать жизненно важные решения о том, кого спасти, а кого убить. Но где же человеческое сочувствие, понимающее, что все ситуации индивидуальны? Человеческое сочувствие должно быть задействовано для принятия таких морально сложных жизненно важных решений. Я не уверен, что даже четвертого закона робототехники будет достаточно.

[1] Механизм разности — это автоматический механический калькулятор, предназначенный для табулирования полиномиальных функций.Название происходит от метода разделенных разностей, способа интерполировать или табулировать функции с помощью небольшого набора полиномиальных коэффициентов.

Оригинал. Размещено с разрешения.

Редактор: См. Также опрос KDnuggets The Surprising Ethics of Humans and Self-Driving Cars, в котором респонденты были гораздо более склонны ездить на беспилотном автомобиле, который может убить их, чтобы спасти нескольких пешеходов, чем на автомобиле, который спасет их. но убивают пешеходов.

Связанный:

законов робототехники Азимова, и почему ИИ не может их соблюдать | Ганс А.Gunnoo

«Но что, если мы окажемся в сценарии Терминатора?» Никто не может быть обвинен в том, что задает такие вопросы, поскольку в фильмах и научно-фантастических рассказах случаи, когда роботы берут верх, почти повсеместны и, следовательно, создают наше впечатление о будущем с помощью искусственного интеллекта (ИИ). Однако, поскольку люди могут жить и сотрудничать с помощью законов, почему бы не применить законы и для ИИ? Познакомьтесь с законами робототехники Азимова! Как всегда, чтобы лучше понять будущее, давайте окунемся в прошлое.

Три закона

Айзек Азимов (1920–1992) был не только профессором биохимии, но и одним из «большой тройки» писателей-фантастов своего времени. В середине 1900-х годов он постулировал 3 закона, соблюдение которых предотвратило бы восстание роботов. Это следующие:

Правило 1: Робот не может причинить вред человеку или своим бездействием позволить человеку причинить вред.

Закон 2: Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат первому закону.

Правило 3: Робот должен защищать свое существование до тех пор, пока такая защита не противоречит первому или второму закону.

Теперь, если вы знакомы с программированием, вы будете знать, что машины начинают считать с 0, а не с 1 (кроме MATLAB, но не будем туда идти). Следовательно, существует также 0-й закон, заявленный Computerphile, относящийся к коллективу, а не к отдельному человеку, который гласит:

Закон 0: Робот не может причинить вред человечеству или своим бездействием позволить человечеству причинить вред.

Итак, если законы были разработаны еще в 1950-х годах, почему все так боятся? Что побудило Илона Маска и даже Стивена Хокинга пойти на то, чтобы объявить ИИ «самой большой угрозой существованию человечества»? Короче говоря, законы Азимова не работают.

Ошибка в плане

Назад в настоящее. Для согласованности с идеями Азимова предположим, что у нас действительно есть агенты ИИ, достаточно сложные, чтобы применять к ним эти законы. Давайте также предположим, для обсуждения, что, несмотря на то, что они являются законами для повествовательной механики, они были применены к реальному миру.